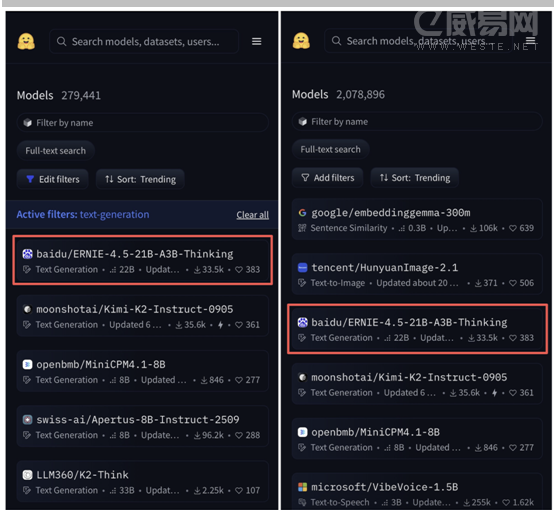

據(jù)介紹,ERNIE-4.5-21B-A3B-Thinking 采用了混合專家(MoE) 架構(gòu),總參數(shù)規(guī)模達(dá)21B,每個 token 激活 3B參數(shù),通過指令微調(diào)及強化學(xué)習(xí)訓(xùn)練。ERNIE-4.5-21B-A3B-Thinking 是在 ERNIE-4.5-21B-A3B 基礎(chǔ)上訓(xùn)練的深度思考模型,支持 128K 的上下文窗口,適用于需要長上下文的復(fù)雜推理任務(wù)。該模型不僅在邏輯推理、數(shù)學(xué)、科學(xué),代碼與文本生成等需要人類專家的任務(wù)上實現(xiàn)了顯著提升,還具備高效的工具調(diào)用能力,能夠支持復(fù)雜任務(wù)的自動化處理。

公開資料顯示,ERNIE-4.5-21B-A3B-Thinking 作為一款 21B 總參數(shù)量,激活僅 3B 的輕量級模型,在各項測試中的表現(xiàn)緊追業(yè)界頂級大尺寸模型,以輕量級規(guī)模實現(xiàn)了接近 SOTA 的智能表現(xiàn)。

就在不久前,WAVE SUMMIT深度學(xué)習(xí)開發(fā)者大會2025上,百度還正式發(fā)布文心大模型X1.1深度思考模型,該模型在事實性、指令遵循、智能體等能力上均有顯著提升。